减少重复性工作

利用机器学习减少重复性手动任务,最大程度地减少维护健康服务所需的重复性工作。

缩短时间

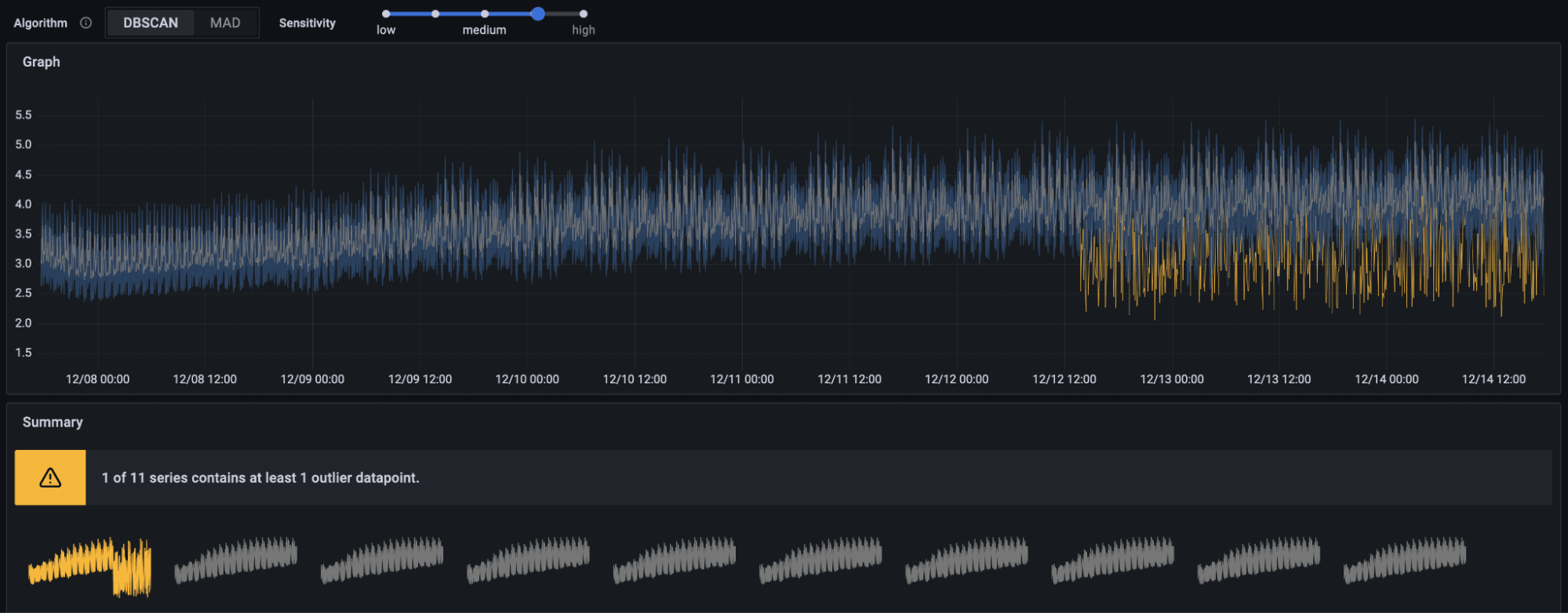

通过自动化检查帮助识别异常和自动化工作流来关联问题,从而加快事件响应时间。

节省成本

使用 Adaptive Metrics 等 AI 工具,汇聚未使用或部分使用的指标,从而降低随规模增长而带来的额外成本。

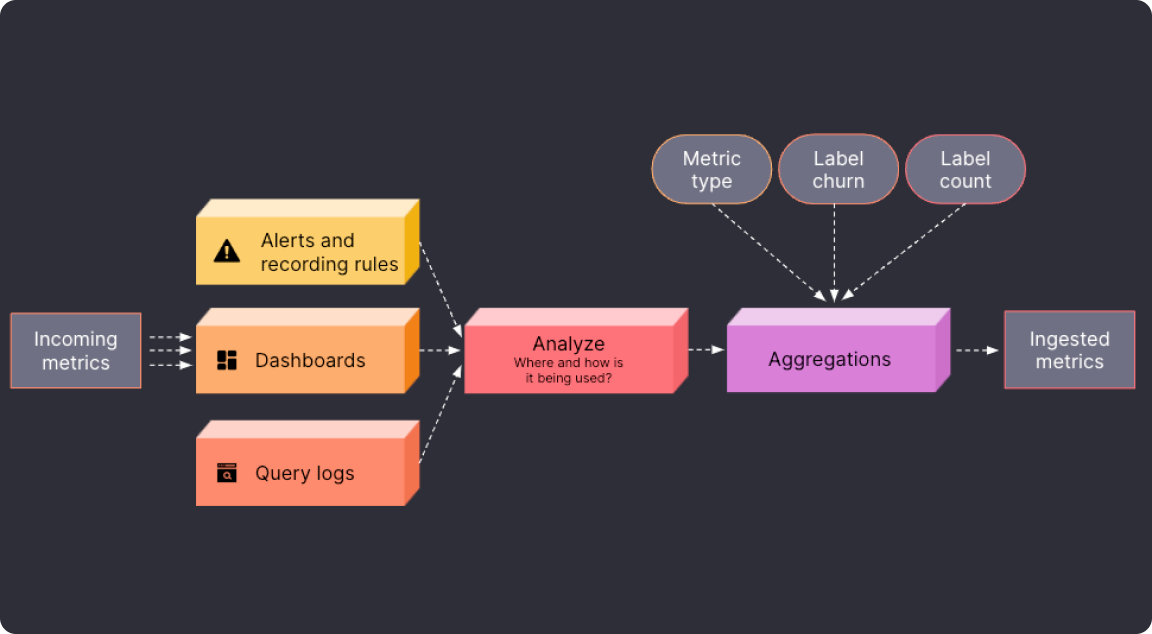

减少指标量以降低成本

使用 Adaptive Metrics,轻松识别指标是未使用还是部分使用,并将其汇聚为低基数版本。平均而言,企业已能将指标成本降低 35%。

- 接收每日更新的、适应您使用模式的建议

- 直接在 UI 中通过规则管理按需应用或跳过聚合

- 识别并隔离可从聚合中排除的关键指标

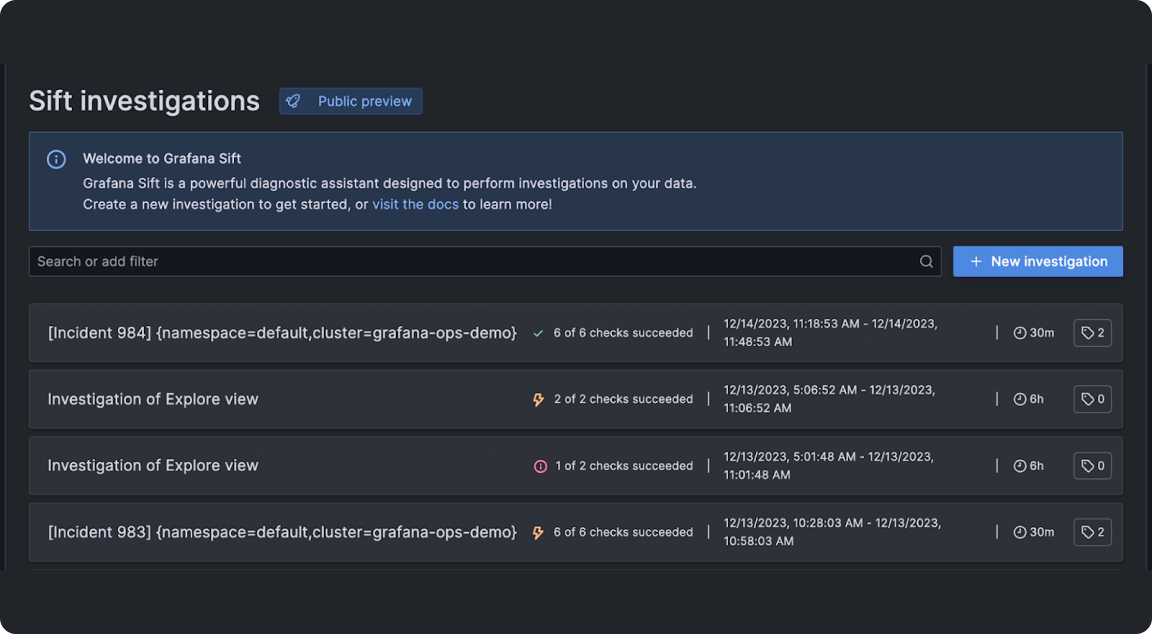

提高 MTTR

Sift 是 Grafana Cloud 的诊断助手,利用Grafana 机器学习过滤数据,识别最关键的事件详情,例如错误模式或 Kubernetes 容器故障

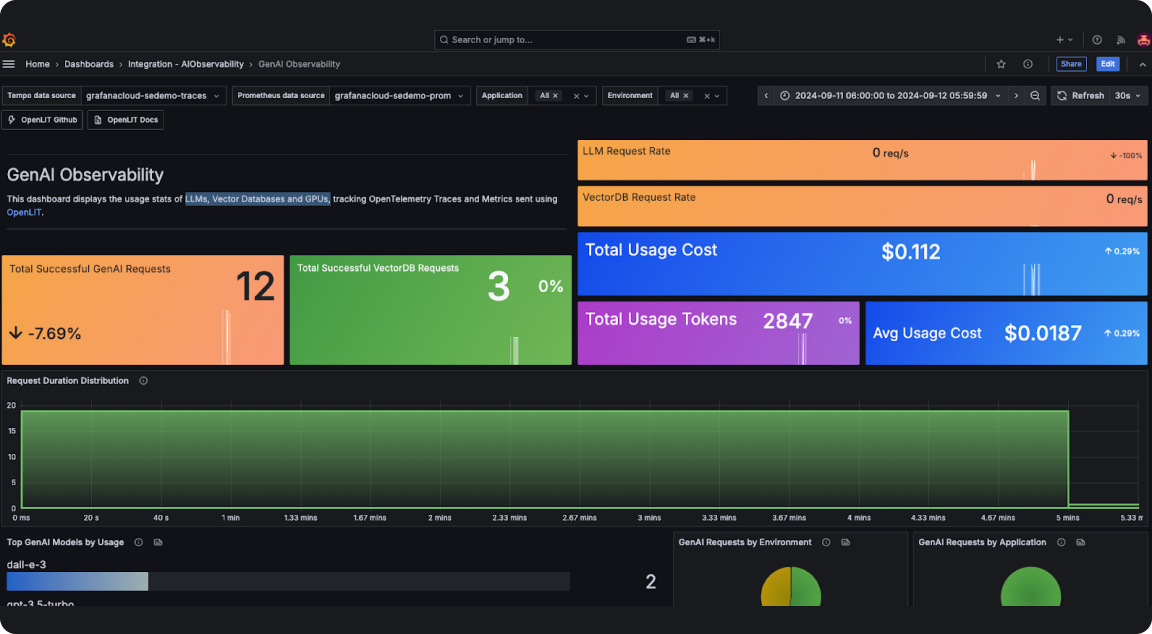

适用于您的技术栈的 AI 可观测性

Grafana Cloud 中的 AI 可观测性通过深入了解 LLMs、向量数据库和 GPUs,帮助团队监控和优化生成式 AI 应用程序。

- 监控用户与 LLMs 的交互,例如提示词和补全结果,以更好地了解用户意图和模型性能。

- 跟踪和可视化 LLM 交互的 token 使用情况,以优化资源分配。

- 实时监控和分析与 LLMs 相关的成本,以实现有效的预算管理、预测和成本节省。

- 捕获每个 LLM 请求的元数据,包括请求参数、响应时间、模型版本及其他详细信息。

- 跟踪每个请求的延迟,以识别瓶颈并实现快速问题解决。

- 监控您的向量数据库查询响应时间和吞吐量性能,以确保高效处理和检索向量数据查询。

更好更快地运行应用程序

利用 GenAI 功能取代繁琐任务,减少重复性工作。

- 使用Grafana 事件自动摘要一键收集重要的事件后复查详情

- 使用火焰图 AI 加速故障排查,该功能通过 LLM 解释火焰图数据

- 为您的 Grafana 仪表盘获取AI 生成的标题和描述

Grafana Labs 的 AI/ML 创新

Grafana Labs 通过其独特的创新方法将可观测性与先进的 AI 和机器学习相结合:在开放环境中开发,将 AI 支持集成到开源解决方案中,并提供零供应商锁定。开发者可以轻松使用 Grafana 的 LLM(大型语言模型)插件并利用其开源库和示例来构建 AI/ML 驱动的体验。

随着 LLMs 在客户日常工作中的日益普及,Grafana Labs 也在开发各种方法来监控和观测 LLMs。我们的工程师探索了使用开源工具观测 LLMs 的方法,包括 OpenLIT SDK。该 SDK 为 LLM 调用生成 OpenTelemetry 追踪和指标,包括延迟、成本和生成的 token 数量。数据可以发送到 Grafana Cloud(通过一个开源且可在 GitHub 上获取的集成)并使用 AI 可观测性解决方案进行可视化。团队还使用 eBPF 构建了 GPU 监控功能,这有助于 AI 开发者在无需手动插桩的情况下获取关于其工作负载的细粒度信息。此功能目前在 Grafana Labs 的开源 eBPF 项目 Grafana Beyla 的分支中提供。