减少繁琐的工作

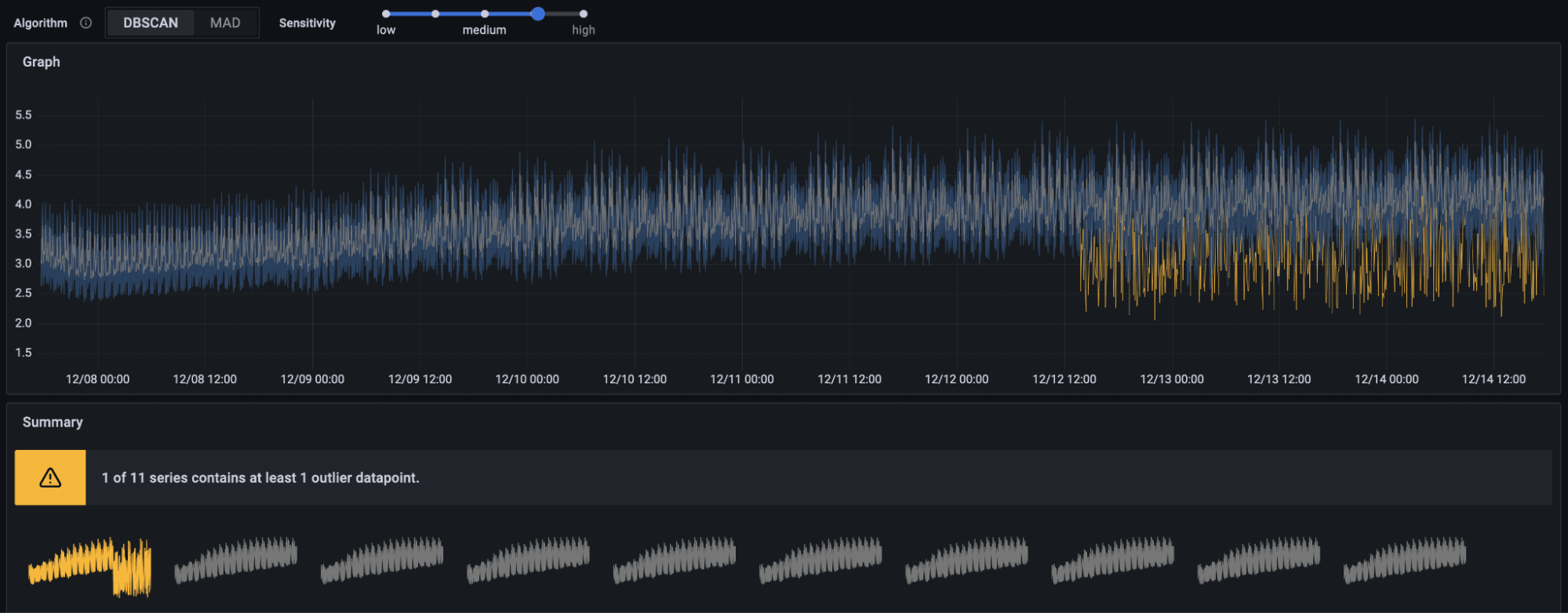

使用机器学习减少重复性手动任务,以最大限度地减少维护健康服务的繁琐工作。

最小化时间

通过自动化检查帮助识别异常和自动化工作流程关联问题的自动化检查,以获得更快的故障响应时间。

节省资金

使用如自适应指标等 AI 驱动的工具来减少扩展带来的额外成本。

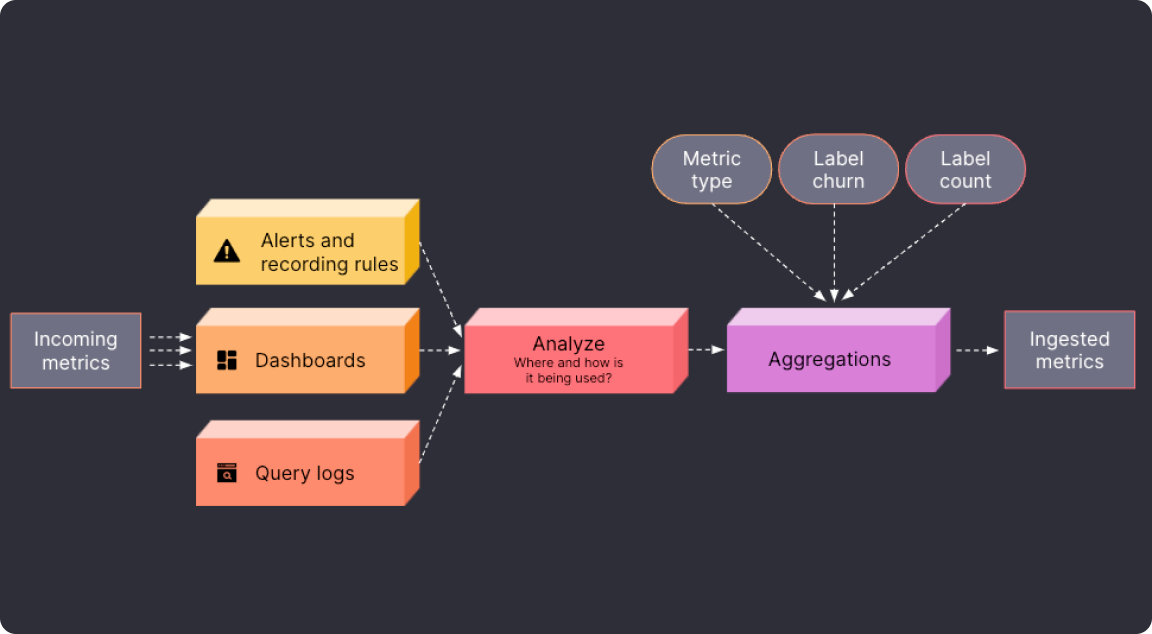

减少指标量以降低成本

轻松识别指标是否 未使用或部分使用,并将它们聚合到低基数版本中,使用自适应指标。平均而言,公司已经能够将指标成本降低 35%。

- 接收每日更新的推荐,这些推荐会根据您的使用习惯进行调整

- 根据需要使用规则管理直接在 UI 中应用或跳过聚合

- 识别和隔离可以排除在聚合之外的临界指标

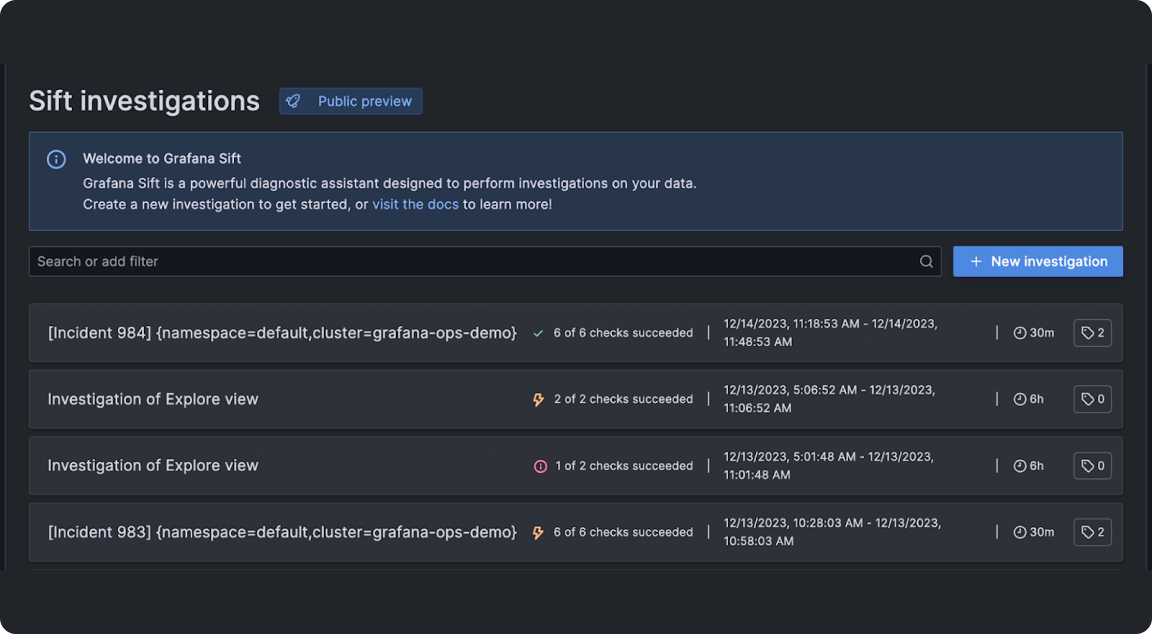

提高MTTR(平均修复时间)

Sift,Grafana Cloud的诊断助手,利用Grafana机器学习来筛选数据并识别最关键的故障细节,如错误模式或Kubernetes容器故障

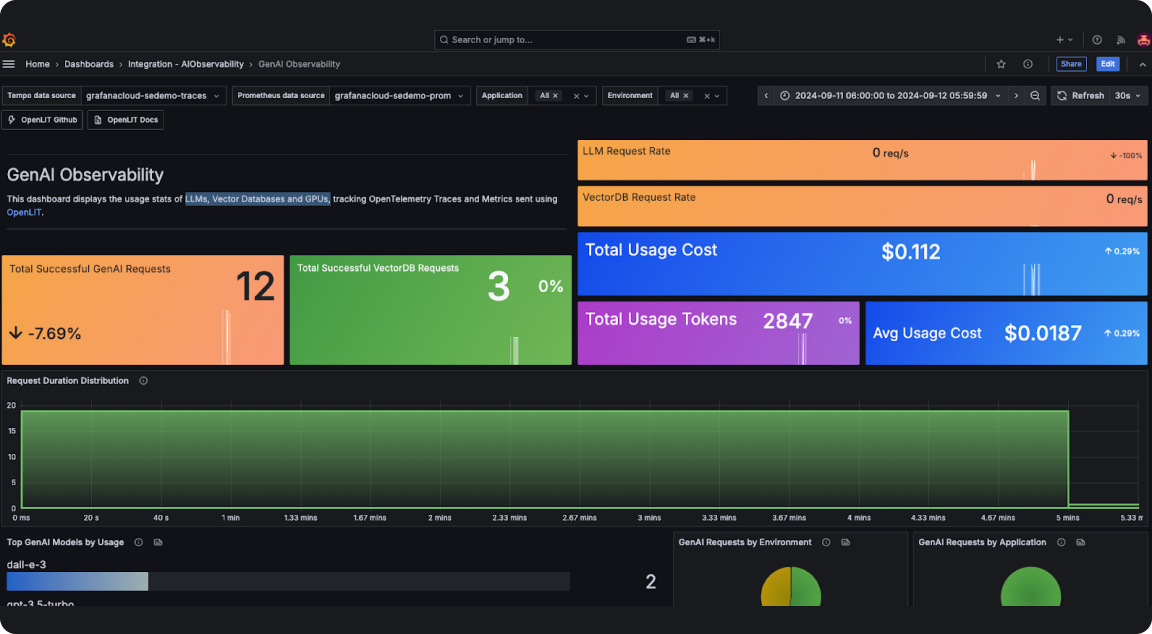

堆栈的AI可观察性

Grafana Cloud的AI可观察性有助于团队监控和优化生成式AI应用程序,深入了解LLMs、向量数据库和GPU。

- 监控与LLMs的用户交互,如提示和完成,以更好地理解用户意图和模型性能。

- 跟踪和可视化LLM交互的令牌使用情况,以优化资源分配。

- 实时监控与LLMs相关的成本,以实现有效的预算管理、预测和成本节约。

- 捕获每个LLM请求的元数据,包括请求参数、响应时间、模型版本和其他详细信息。

- 跟踪每个请求的延迟,以识别瓶颈并实现问题快速解决。

- 监控向量数据库查询响应时间和吞吐量性能,以确保高效处理和检索向量数据查询。

更好地更快地运行应用程序

用减少劳作的GenAI功能替换繁琐的任务。

- 使用Grafana事件自动摘要一键收集重要的事件后审查细节

- 使用火焰图AI加快PromQL查询的创建,它通过LLM解释火焰图数据

- 使用生成式AI更快地创建PromQL查询

- 为您的Grafana仪表板获取AI生成的标题和描述

Grafana Labs的AI/ML创新

Grafana Labs通过其独特的创新方法:在开源中开发、将AI支持构建到开源解决方案中,并提供零供应商锁定,将可观察性与高级AI和机器学习相结合。开发者可以使用Grafana的LLM(大型语言模型)插件轻松构建AI/ML驱动的体验,并利用其开源库和示例。

随着大型语言模型(LLMs)在日常工作中越来越普及,Grafana Labs也在开发各种方法来监控和观察LLMs。我们的工程师已经探索了使用开源工具来观察LLMs的方法,包括OpenLIT SDK。此SDK为LLM调用生成OpenTelemetry跟踪和指标,包括延迟、成本和生成的令牌数量。这些数据可以通过GitHub上的开源集成发送到Grafana Cloud,并使用AI可观察性解决方案进行可视化。团队还使用eBPF构建了GPU监控,这有助于AI开发者在不进行手动配置的情况下获取其工作负载的详细信息。目前,这作为Grafana Beyla的一个分支可用,Grafana Labs的开源eBPF项目。